MatAnyone – 南洋理工和商汤科技推出的人像视频抠图框架

来源:爱论文

时间:2025-03-22 14:45:35

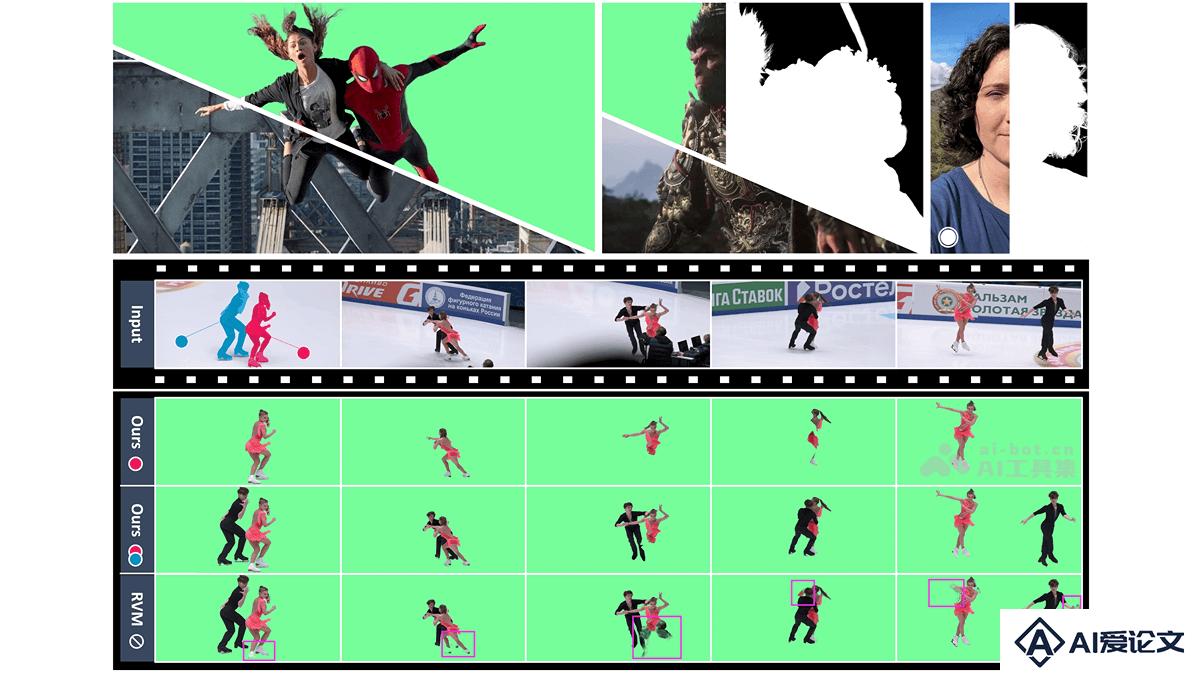

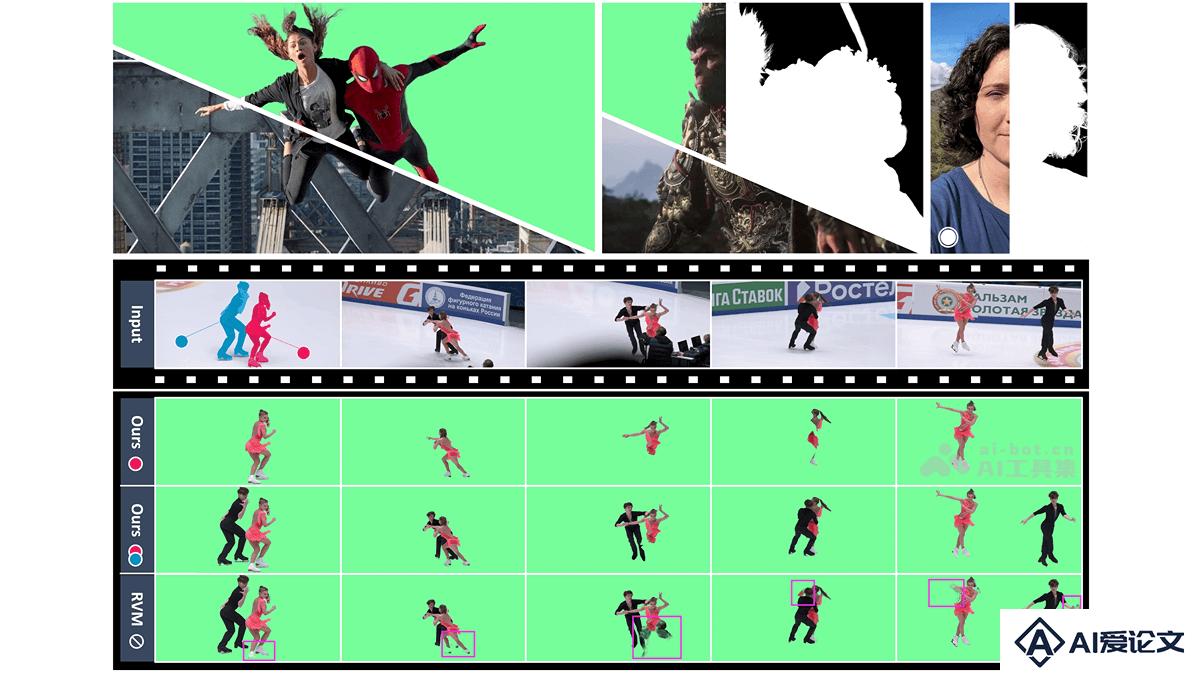

MatAnyone是什么

MatAnyone是南洋理工大学S-Lab实验室和商汤科技推出的,针对复杂背景人像视频抠图的先进框架,专注于目标指定的视频抠图任务。MatAnyone基于一致的内存传播模块和区域自适应内存融合技术,确保在视频序列中核心区域的语义稳定性和边界细节的精细度。MatAnyone引入新的训练策略,用大规模分割数据直接监督抠图头,显著提升模型在真实场景下的稳定性和泛化能力。MatAnyone配备了高质量、多样化的训练数据集VM800和更具挑战性的测试数据集YoutubeMatte,为模型训练和评估提供坚实基础。

MatAnyone的主要功能

稳定的目标跟踪:在整个视频中稳定地跟踪目标对象,在复杂或模糊的背景中保持目标的完整性。精细的边界细节提取:支持生成高质量的alpha遮罩,尤其是在边界区域(如头发、边缘等)表现出色,提供图像级的细节精度。适应多种视频类型:MatAnyone能处理不同类型的视频,包括电影、游戏、智能手机视频等,适应多种帧尺寸和媒体格式。交互性增强:用户能在第一帧指定目标分割掩码引导整个视频的抠图过程,实现更精准的交互式视频编辑。

MatAnyone的技术原理

一致内存传播:内存融合:CMP模块基于估计当前帧与前一帧之间的alpha值变化,自适应地融合来自前一帧的信息。对于“大变化”区域(通常位于边界),更多依赖当前帧的信息;对于“小变化”区域(通常位于核心区域),保留前一帧的内存。区域自适应:基于轻量级的边界区域预测模块,估计每个查询令牌的变化概率,实现区域自适应的内存融合,显著提高核心区域的语义稳定性和边界区域的细节精度。核心区域监督:分割数据的直接监督:为克服真实视频抠图数据稀缺的问题,MatAnyone用大规模真实分割数据直接监督抠图头。基于在核心区域使用像素级损失(Lcore)和在边界区域使用改进的DDC损失(Lboundary),确保语义稳定性和细节精度。改进的DDC损失:基于调整DDC损失的计算方式,使其更适合视频抠图任务,避免传统DDC损失在边界区域产生的锯齿状和阶梯状边缘。新数据集和训练策略:高质量训练数据集:引入新的训练数据集VM800,规模是现有数据集VideoMatte240K的两倍,且在核心和边界区域的质量更高,显著提升模型的训练效果。多阶段训练:采用多阶段训练策略,先在视频抠图数据上初始化模型,基于分割数据进行核心区域监督,最后用图像抠图数据进一步优化边界细节。网络架构:编码器:采用ResNet-50作为编码器,提取特征并生成查询和键。对象变换器:基于对象变换器模块,将像素级内存按对象语义进行分组,减少低层次像素匹配带来的噪声。解码器:解码器基于多级上采样和跳跃连接,生成高精度的alpha遮罩。值编码器:将预测的alpha遮罩和图像特征编码为值,用在更新内存库。

MatAnyone的项目地址

项目官网:https://pq-yang.github.io/projects/MatAnyone/GitHub仓库:https://github.com/pq-yang/MatAnyonearXiv技术论文:https://arxiv.org/pdf/2501.14677

MatAnyone的应用场景

影视后期制作:用在背景替换和特效合成,将演员从原始背景中精准抠出,替换为虚拟或特效背景,提升画面的视觉效果和创意空间。视频会议与直播:在视频会议和直播中,实时将人物从复杂背景中分离出来,替换为虚拟背景或模糊背景,增强隐私保护和视觉效果。广告与营销:在广告视频制作中,将产品或人物从拍摄背景中抠出,替换为更具吸引力的背景,提升广告的视觉冲击力和吸引力。游戏开发:用在游戏中的视频内容制作,如角色动画、过场动画等,将角色从拍摄背景中精准抠出,替换为游戏场景,增强游戏的沉浸感。虚拟现实与增强现实:在VR和AR应用中,将用户或物体从现实场景中抠出,融合到虚拟环境中,提升用户体验和交互效果。

相关资讯

相关资讯 2023-04-14

2023-04-14

下载

下载