Boximator是什么?

Boximator是由字节跳动的研究团队开发的一种视频合成技术,旨在生成丰富且可控的运动,以增强视频合成的质量和可控性。该技术通过引入两种类型的约束框(硬框和软框)来实现对视频中对象位置、形状或运动路径的精细控制。

官方项目主页:https://boximator.github.io/Arxiv研究论文:https://arxiv.org/abs/2402.01566

Boximator的工作原理

Boximator的工作原理基于视频扩散模型,它通过引入一种新的控制机制来增强视频合成的精细度和可控性。以下是Boximator工作原理的关键步骤:

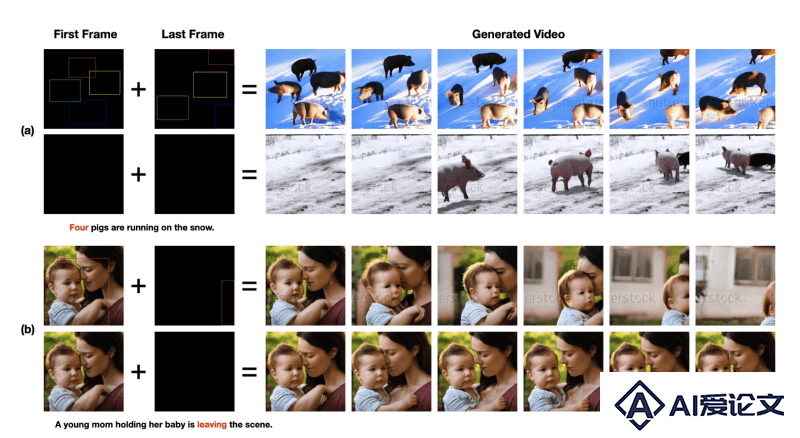

对象选择与框定义:用户在视频的起始帧或条件帧中使用硬框(Hard Box)来选择和精确定位对象。这些硬框定义了对象的精确边界。对于需要更宽松控制的场景,用户可以定义软框(Soft Box),这些框提供了一个对象必须存在的大致区域,允许对象在该区域内自由移动。对象ID与框关联:Boximator为每个对象分配一个唯一的对象ID,这个ID以RGB颜色空间表示,使得每个对象的框都有一个独特的“颜色”。这样,模型可以跨帧跟踪和控制同一个对象。视频扩散模型集成:Boximator作为一个插件,与现有的视频扩散模型(如PixelDance和ModelScope)集成。在训练过程中,基础模型的权重被冻结,以保留其预训练的知识,而只训练新增的控制模块。自跟踪技术:为了简化模型学习框-对象关联的过程,Boximator引入了自跟踪技术。在训练阶段,模型被训练生成彩色的边界框,这些框的颜色与对象ID相对应。模型需要在每一帧中生成正确的框并将其与Boximator的约束对齐。多阶段训练过程:Boximator的训练分为三个阶段。第一阶段使用硬框约束,帮助模型建立对坐标和ID的基本理解。第二阶段引入软框,通过随机扩展硬框来增加训练的难度。第三阶段继续使用软框,但不生成可见的边界框,而是让模型内部保留这种关联。推理阶段:在推理(生成视频)阶段,Boximator在用户定义的框之外的帧中插入软框。这些软框通过线性插值和放松处理来生成,确保对象大致遵循预期的运动轨迹,同时给予模型足够的灵活性来引入变化。运动控制与质量评估:Boximator通过平均精度(AP)分数来评估运动控制的准确性,这涉及到比较生成的视频中的检测到的边界框与真实边界框的一致性。视频质量则通过Fréchet Video Distance(FVD)分数和CLIP相似性分数(CLIPSIM)来衡量。通过这些步骤,Boximator能够在视频合成过程中实现对对象运动的精细控制,同时保持视频的高质量和逼真度。

相关资讯

相关资讯 2023-04-14

2023-04-14

下载

下载