Sitcom-Crafter – 北航联合港中文等高校推出的 3D 人类动作生成系统

来源:爱论文

时间:2025-03-15 11:24:02

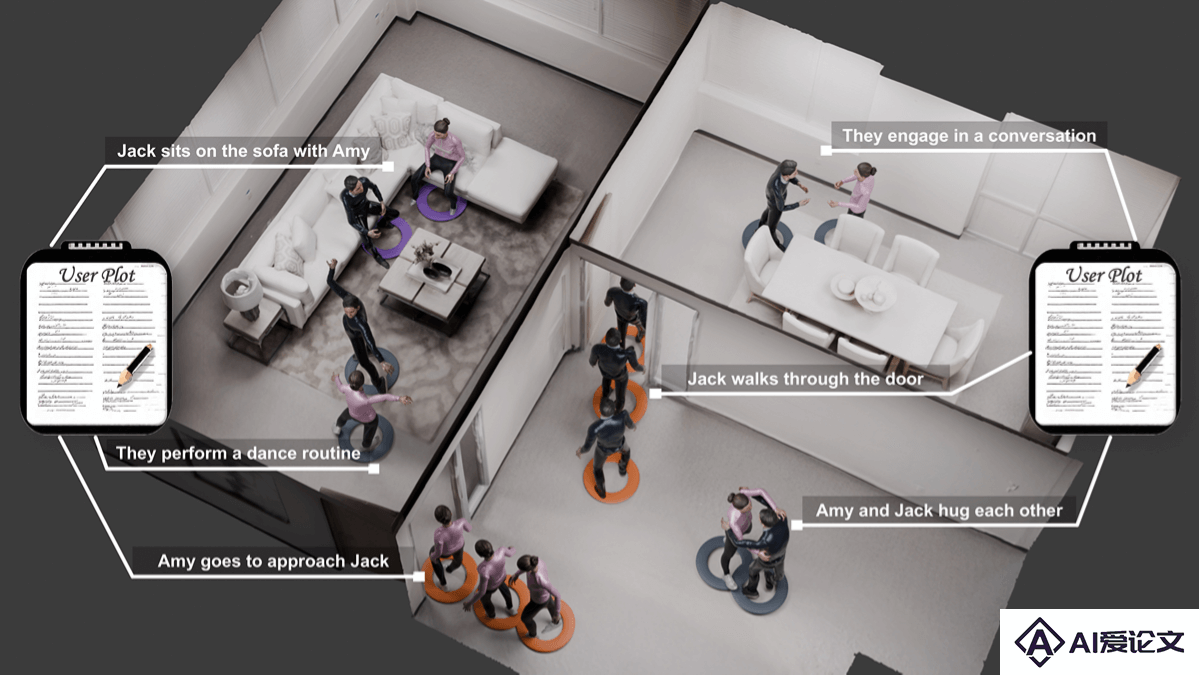

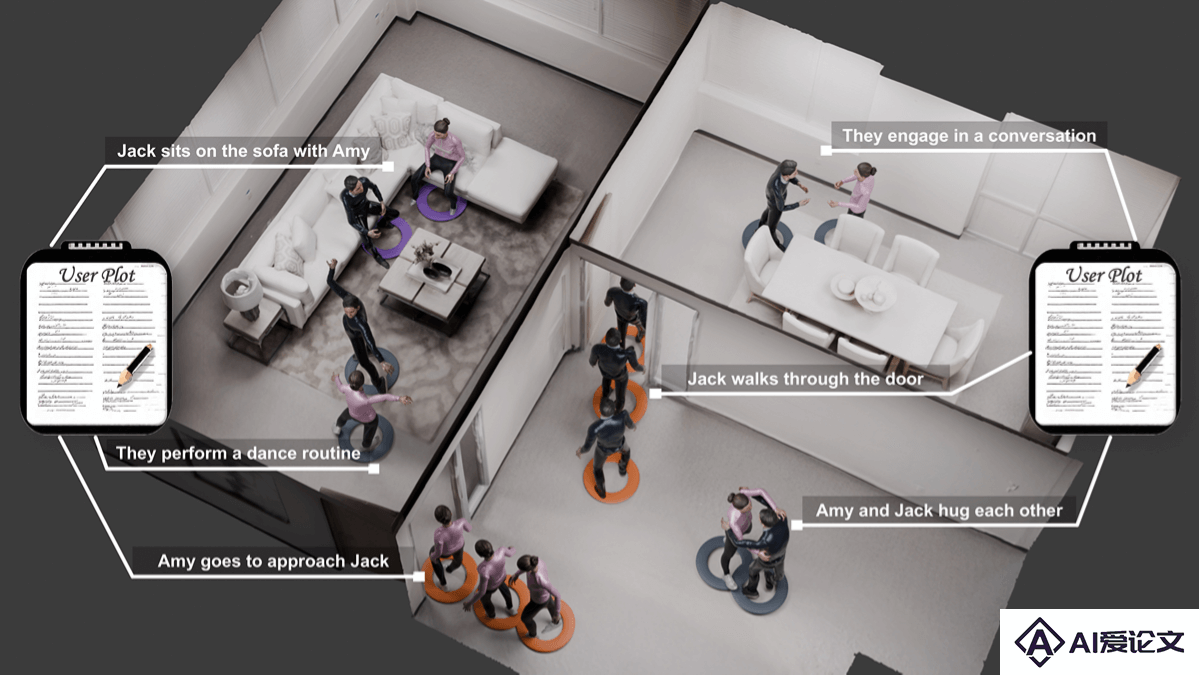

Sitcom-Crafter是什么

Sitcom-Crafter 是北京航空航天大学、香港中文大学(深圳)、悉尼科技大学、中山大学等高校联合推出的 3D 场景中人类动作生成系统。基于用户提供的长剧情指导,生成多样化且物理真实的动作,包括人类行走、人类与场景交互及人类之间交互。系统包含八大模块,其中三大核心模块负责动作生成,五大增强模块用于优化动作流畅性、同步性、碰撞修正等。Sitcom-Crafter 创新的 3D 场景感知技术和自监督 SDF 策略,无需额外数据采集,生成符合物理逻辑的动作,显著提升了创作效率,为动画和游戏设计提供高效、智能化的解决方案。

Sitcom-Crafter的主要功能

人类行走:角色在 3D 场景中自然行走。人类与场景交互:角色与环境物体进行符合物理逻辑的交互。人类之间交互:角色之间进行协调的动作生成,减少碰撞并优化动作同步。增强功能:剧情解析:AI自动拆解剧本,转化为具体的角色动作指令运动同步:确保不同模块生成的运动在时间上保持一致。手部姿态增强:通过检索数据库中的手部姿态来增强运动的自然性。碰撞修正:自动检测并修正人物之间的碰撞。3D重定向:将生成的运动映射到现有的3D数字人物模型,提升视觉效果。

Sitcom-Crafter的技术原理

运动生成模块:人类行走生成:基于现有的先进方法(如GAMMA),通过深度学习模型生成人物的行走运动。人与场景交互生成:基于DIMOS等方法,结合场景信息生成人物与场景物体的交互运动。人与人交互生成:用自监督的场景感知方法,合成3D场景中的SDF(签名距离函数)点模拟周围环境,避免人物与场景的碰撞。基于扩散模型(diffusion model)生成多人交互,考虑人物之间的相对位置和运动。场景感知技术:SDF点合成:基于预处理运动数据,定义运动区域并随机生成周围物体的SDF点,模拟场景中的障碍物。碰撞检测与修正:SDF点检测人物与场景或彼此之间的碰撞,调整运动轨迹或速度避免碰撞。剧情理解与命令生成:用大型语言模型(如Gemini 1.5)解析剧情文本,转化为具体的运动指令。基于自然语言处理技术,将复杂的剧情分解为多个运动命令,分配给相应的运动生成模块。增强模块:运动同步:基于插值技术(如Slerp)确保不同模块生成的运动在时间上平滑过渡。手部姿态检索:CLIP模型检索与文本描述最相似的手部姿态,融入生成的运动中。碰撞修正:调整运动速度或路径,避免人物之间的碰撞。3D重定向:将生成的运动映射到高质量的3D数字人物模型,提升视觉效果。统一的运动表示:系统采用标记点(marker points)作为统一的运动表示,支持从不同数据源(如SMPL、SMPL-X模型)提取运动数据,增强系统的扩展性和兼容性。

Sitcom-Crafter的项目地址

项目官网:https://windvchen.github.io/Sitcom-Crafter/GitHub仓库:https://github.com/WindVChen/Sitcom-CrafterarXiv技术论文:https://arxiv.org/pdf/2410.10790

Sitcom-Crafter的应用场景

动画制作:快速生成角色运动,减少手动动画工作量,支持多样化动作和剧情驱动的动画设计。游戏开发:为NPC设计自然行为和交互动作,支持动态剧情生成和实时动作反馈,提升游戏沉浸感。虚拟现实(VR)和增强现实(AR):生成虚拟角色的自然交互和场景模拟,增强用户体验和交互自然性。影视制作:用在早期创意验证、特效场景设计和动作捕捉替代,提升制作效率。教育和培训:生成模拟训练中的角色行为,创建虚拟教学助手,支持安全演示和复杂场景教学。

相关资讯

相关资讯 2023-04-14

2023-04-14

下载

下载