Light-A-Video – 上海AI Lab联合交大等高校推出的视频重照明方法

来源:爱论文

时间:2025-03-18 11:46:38

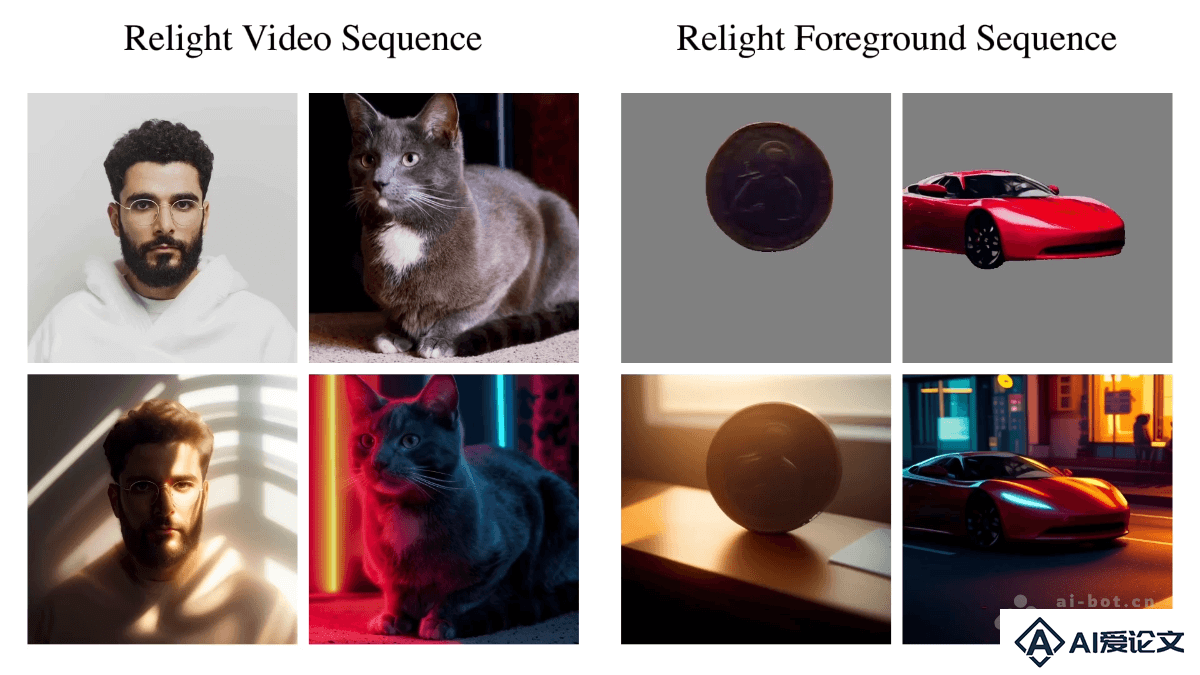

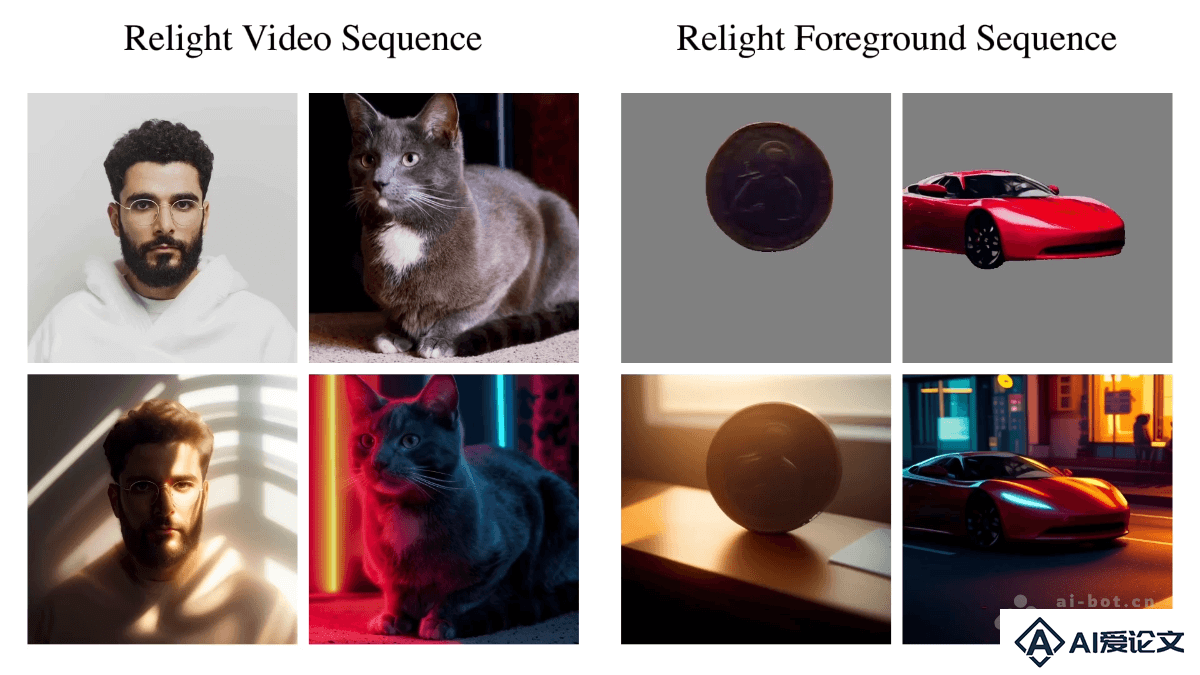

Light-A-Video是什么

Light-A-Video 是上海交通大学、中国科学技术大学、香港中文大学、香港科技大学、斯坦福大学及上海AI实验室的共同推出的无需训练的视频重照明方法,基于渐进式光照融合技术实现高质量、时间上一致的视频光照控制。Light-A-Video两个关键模块实现:一致光照注意力(Consistent Light Attention, CLA)和渐进式光照融合(Progressive Light Fusion, PLF)。CLA 基于增强帧间交互,稳定背景光照源的生成;PLF 基于视频扩散模型的运动先验,逐步将重照明效果融入视频中,确保光照过渡的平滑性。Light-A-Video 支持对整个视频进行重照明,对前景序列进行重照明生成背景。

Light-A-Video的主要功能

时间一致性:基于增强帧间光照的一致性,避免视频闪烁和光照不连续的问题。高质量重照明:用预训练的图像重照明模型,对视频中的每一帧进行光照调整,同时保持图像质量。前景与背景分离处理:支持对视频前景进行重照明,自动生成与光照条件一致的背景。零样本(Zero-shot)生成:无需额外训练或优化,直接根据文本提示生成符合光照条件的视频。兼容性强:与多种流行的视频生成模型(如 AnimateDiff、CogVideoX 等)兼容,具有广泛的适用性。

Light-A-Video的技术原理

Consistent Light Attention (CLA):CLA 模块基于增强帧间交互来稳定光照源的生成。在图像重照明模型的自注意力层中引入跨帧信息,基于时间平均特征抑制光照的高频抖动,生成稳定的背景光照。CLA 用双流注意力融合策略:一条流处理原始帧信息,保留细节;另一条流基于时间平均处理,抑制抖动。最终通过加权平均融合两种流的输出。Progressive Light Fusion (PLF):PLF 模块用视频扩散模型(VDM)的运动先验,逐步将重照明效果融入视频中。基于线性融合的方式,将重照明的图像外观与原始视频外观结合,确保光照过渡的平滑性。PLF 在视频扩散模型的去噪过程中逐步调整光照目标,基于动态调整融合权重,逐渐引导视频去噪方向,实现时间上一致的重照明效果。整体流程:输入视频首先被编码为潜在空间中的噪声信号,通过 VDM 的去噪过程逐步恢复。在每一步去噪中,CLA 和 PLF 模块协同工作,将重照明信息逐步注入到视频中。

Light-A-Video的项目地址

项目官网:https://bujiazi.github.io/light-a-video.github.io/GitHub仓库:https://github.com/bcmi/Light-A-Video/arXiv技术论文:https://arxiv.org/pdf/2502.08590

Light-A-Video的应用场景

影视后期:快速调整光照条件,如白天变夜晚,节省成本和时间。游戏开发:动态改变场景光照,增强沉浸感。视频创作:快速改变视频风格,满足创意需求。VR/AR:实时调整光照,提升虚拟与现实融合效果。视频会议:优化视频光照,改善远程协作体验。

相关资讯

相关资讯 2023-04-14

2023-04-14

下载

下载