s1是什么

s1是斯坦福大学和华盛顿大学的研究团队开发的低成本、高性能的AI推理模型。模型通过“蒸馏”技术从谷歌的Gemini 2.0 Flash Thinking Experimental模型中提取推理能力。研究人员仅使用1000个精心策划的问题及其答案进行训练,训练成本不到50美元,训练过程耗时不到30分钟。S1模型在数学和编程能力测试中表现优异,与OpenAI的o1和DeepSeek R1等顶尖推理模型相当。

来源:爱论文 时间:2025-03-24 10:00:34

s1是斯坦福大学和华盛顿大学的研究团队开发的低成本、高性能的AI推理模型。模型通过“蒸馏”技术从谷歌的Gemini 2.0 Flash Thinking Experimental模型中提取推理能力。研究人员仅使用1000个精心策划的问题及其答案进行训练,训练成本不到50美元,训练过程耗时不到30分钟。S1模型在数学和编程能力测试中表现优异,与OpenAI的o1和DeepSeek R1等顶尖推理模型相当。

相关资讯

更多+

相关资讯

更多+

s1是斯坦福大学和华盛顿大学的研究团队开发的低成本、高性能的AI推理模型。模型通过“蒸馏”技术从谷歌的Gemini 2 0 Flash Thinking Experimental模型中提取推理能力。研究人员仅使用1000个精心策划的问题及其答案进行训练,训练成本不到50美元,训练过程耗时不到30分钟。

AI教程资讯

2023-04-14

2023-04-14

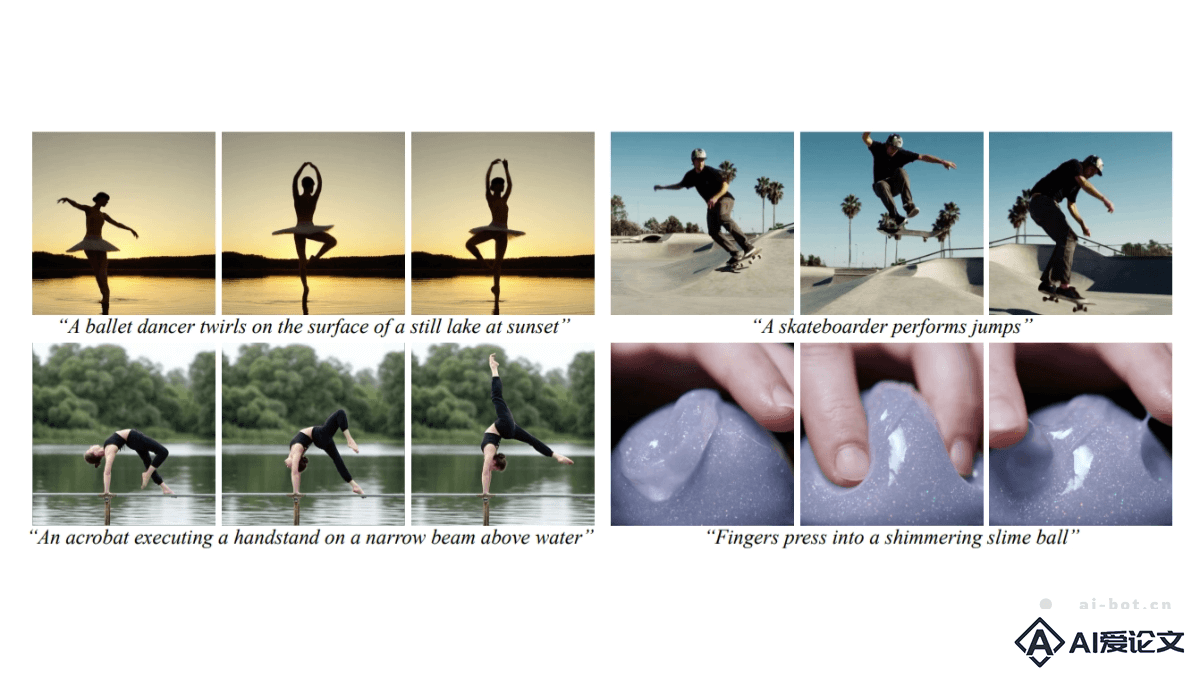

VideoJAM是Meta推出的,用在增强视频生成模型运动连贯性的框架。基于引入联合外观-运动表示,让模型在训练阶段同时学习预测视频的像素和运动信息,在推理阶段基于模型自身的运动预测作为动态引导信号,生成更连贯的运动。

AI教程资讯

2023-04-14

2023-04-14

SynCD(Synthetic Customization Dataset)是卡内基梅隆大学和Meta推出的高质量合成训练数据集,用在提升文本到图像模型的定制化能力。SynCD包含多个相同对象在不同光照、背景和姿态下的图像,基于共享注意力机制(Masked Shared Attention)和3D资产引导(如Objaverse)确保对象在不同图像中的一致性。

AI教程资讯

2023-04-14

2023-04-14

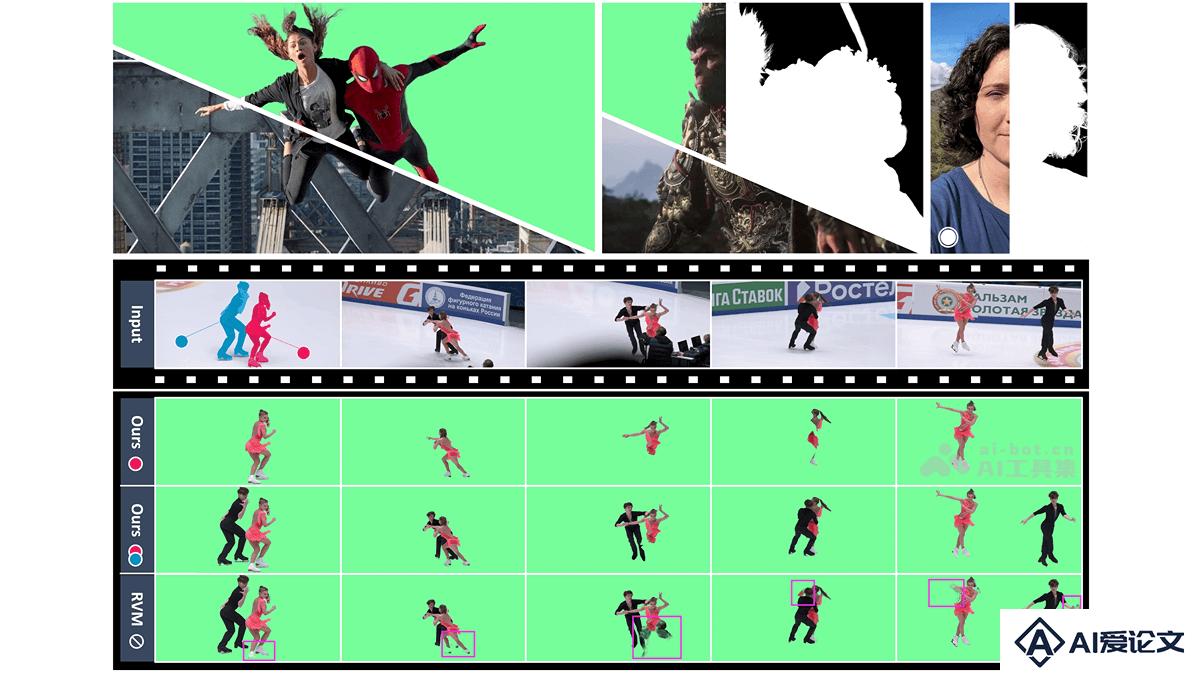

MatAnyone是南洋理工大学S-Lab实验室和商汤科技推出的,针对复杂背景人像视频抠图的先进框架,专注于目标指定的视频抠图任务。MatAnyone基于一致的内存传播模块和区域自适应内存融合技术,确保在视频序列中核心区域的语义稳定性和边界细节的精细度。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+