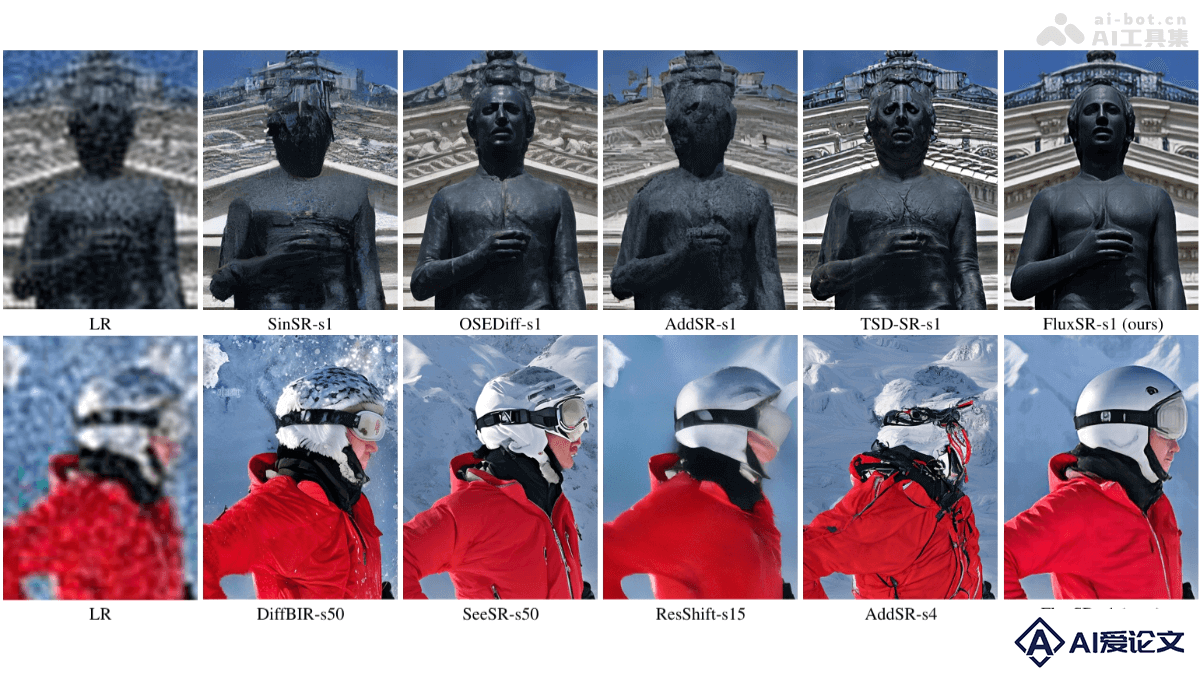

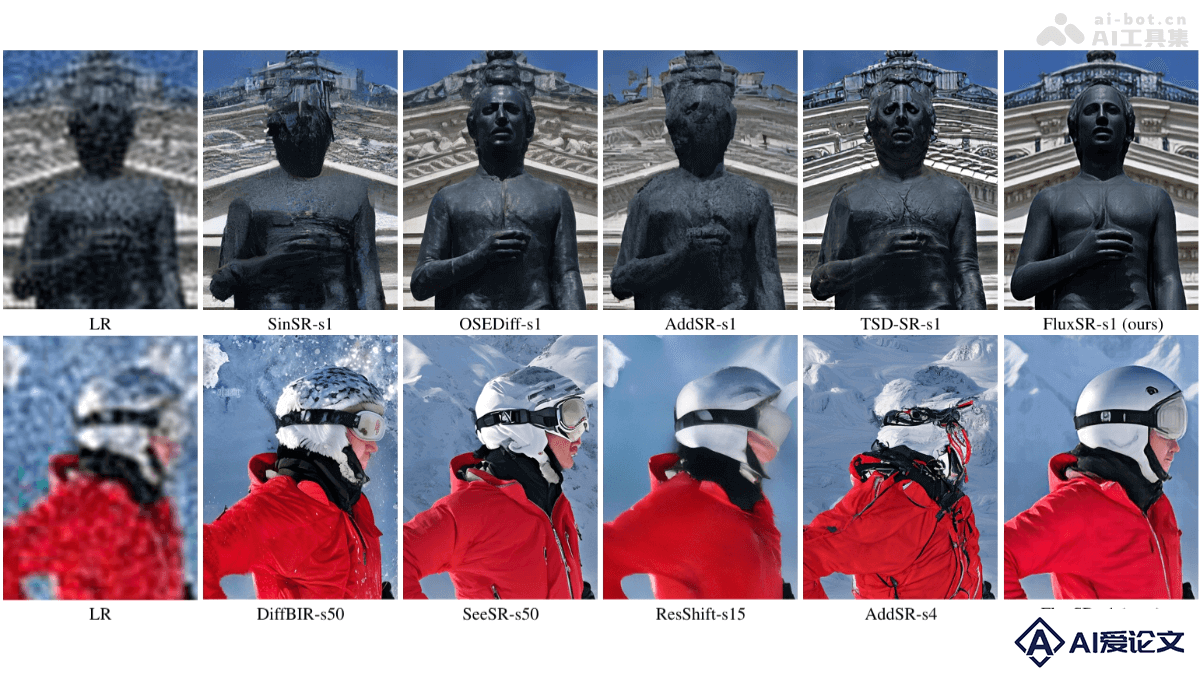

FluxSR – 上海交大联合华为等高校推出的图像超分辨率模型

来源:爱论文

时间:2025-03-24 10:24:55

FluxSR是什么

FluxSR是新型的单步扩散模型,是上海交通大学、哈佛大学、华南理工大学和华为诺亚方舟实验室推出的专门用在真实世界图像超分辨率(Real-ISR)任务。FluxSR基于FLUX.1-dev文本到图像(T2I)扩散模型,通过流轨迹蒸馏(FTD)技术将多步流匹配模型蒸馏为单步超分辨率模型。FluxSR的核心优势在于能在保持T2I模型高真实感的同时,高效地生成高质量的超分辨率图像。FluxSR用TV-LPIPS感知损失和注意力多样化损失(ADL)优化图像高频细节,减少伪影。FluxSR在多个数据集上展现出卓越的性能,尤其在无参考图像质量评估指标上表现突出,显著降低计算成本,为高效、高质量的图像超分辨率提供新的解决方案。

FluxSR的主要功能

高效单步超分辨率重建:在单步扩散过程中将低分辨率图像高效地恢复为高分辨率图像,显著减少计算成本和推理延迟,适合快速图像处理需求。高真实感图像生成:从预训练的文本到图像(T2I)模型中提取高真实感细节,将其应用于超分辨率任务,生成具有丰富细节和高真实感的图像。高频细节恢复与伪影抑制:能有效恢复图像的高频细节,减少高频伪影和重复模式。

FluxSR的技术原理

流轨迹蒸馏(Flow Trajectory Distillation, FTD):噪声到图像流的生成:用预训练的T2I模型生成噪声到图像的流。低分辨率到高分辨率流的推导:基于数学关系推导出LR到HR的流轨迹,避免直接优化SR流导致的分布偏移。单步扩散模型的训练策略:基于对大模型友好的训练策略,离线生成噪声到图像的流数据对,避免在训练过程中依赖额外的教师模型。显著减少内存消耗和训练成本,让单步模型的训练更加高效。感知损失和正则化:TV-LPIPS感知损失:结合总变差(TV)和LPIPS(Learned Perceptual Image Patch Similarity)损失,强调高频分量的恢复并减少生成图像中的伪影。注意力多样化损失(ADL):基于减少变换器中不同token的相似性,增强注意力的多样性,消除高频伪影。高效推理:在推理阶段仅依赖单个流模型,避免多步扩散模型的高计算开销。基于FTD技术,在单步中生成高质量的超分辨率图像,同时保持与多步模型相当的真实感。

FluxSR的项目地址

GitHub仓库:https://github.com/JianzeLi-114/FluxSRarXiv技术论文:https://arxiv.org/pdf/2502.01993

FluxSR的应用场景

老旧照片修复:将低分辨率、模糊或损坏的老照片恢复为高分辨率、清晰的图像。影视制作:在影视后期制作中,将低分辨率的素材提升为高分辨率,适应高清或4K制作需求医学影像增强:提升低分辨率的医学影像(如X光、CT、MRI)的分辨率,帮助医生更准确地诊断疾病。智能手机拍照:提升手机拍摄的低分辨率照片的清晰度,尤其是在低光照或快速运动场景下。质量检测:在工业生产中,提升生产线上的图像检测系统的分辨率,帮助更准确地检测产品缺陷。

相关资讯

相关资讯 2023-04-14

2023-04-14

下载

下载